Le 13 décembre 2012, l’ARCEP a sanctionné Orange et SFR d’une amende de 183 millions d’euros pour pratiques anticoncurrentielles dans le secteur de la téléphonie mobile. Elle leur reproche d’avoir commercialisé, essentiellement entre 2005 et 2008, des offres donnant la possibilité d’appeler en illimité uniquement au sein de leurs réseaux.

« Ces offres ont freiné la concurrence de deux manières.

Elles ont contribué, d’une part, à figer le marché en attirant les consommateurs vers les deux plus gros réseaux et en les verrouillant de fait une fois le choix opéré. Elles ont, d’autre part, été de nature à affaiblir le troisième opérateur,

Bouygues Télécom, qui a dû riposter en lançant des offres qui ont nettement renchéri ses coûts. »

(Communiqué de l’ARCEP, 13 décembre 2012, )

Ce n’est pas la première fois, ni la dernière, qu’une telle chose arrive. Mais pourquoi de telles sanctions ? En quoi la concurrence est-elle si importante ? Quel est le rôle de l’ARCEP, des Autorités de régulations en général ? Et en quoi la régulation est utile au bon fonctionnement de l’économie numérique ?

Pour tenter de répondre à ces questions, il est important au préalable de mieux comprendre cette économie numérique. Il convient cependant de bien distinguer les produits non numériques utilisant le Web comme canal de vente, des produits numériques, en parti dématérialisés, distribués par le Web. Nous ne nous attacherons qu’à ces derniers.

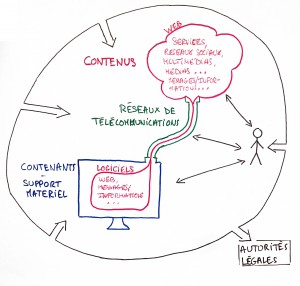

Tout au long de mes recherches, j’ai essayé d’établir une sorte de cartographie représentant ses différents acteurs et ses différents secteurs. Vous y trouverez notamment les sources qui m’ont permit de la mettre en place.

http://www.mindomo.com

Cette cartographie peut-être complétée, toute critique afin de l’améliorer est la bienvenue.

J’y distingue cinq secteurs et acteurs, que je vais vous définir, ce qui me permettra ensuite de révéler les principaux paradoxes et tensions que soulève l’économie numérique avec la régulation.

Parlons d’abord des contenus, c’est à dire de tout ce qui est lu/vu/entendu sur les machines informatiques et transféré sur les réseaux de télécommunication. Selon moi, ils comportent le Web, les logiciels et les médias, qui permettent de lire ou de diffuser tout message/information, sous forme de textes, d’images, audio et/ou vidéo. Avec le développement du Web, la manière de consommer de l’usager a changé, ce qui bouleverse les moyens de diffusion traditionnels des médias. Par exemple, l’industrie du disque subit une chute de son chiffre d’affaires depuis quelques années à cause notamment du piratage des œuvres. Cela entraîne l’émergence d’un nouveau modèle économique pour l’industrie de la musique. Ce modèle est représenté par des plates-formes de téléchargement ou d’écoute en ligne, payantes ou avec publicités, comme iTunes, Deezer ou Spotify. Elles baissent le piratage, mais continue d’affaiblir l’industrie du disques. De plus, on observe la croissance du pouvoir des géants du net dominé par « GAFA » (Google, Apple, Facebook, Amazon), qui vont jusqu’à créer un groupe de pression pour avoir plus d’impact sur la politique (Cf Article du journal le Monde).Aujourd’hui, sur le net presque tout passe par eux, ce qui en dérange plus d’un.

Ensuite, les contenants. Ils représentent tous les supports informatiques/électroniques permettant de lire les contenus. Ce secteur connaît beaucoup de développements, d’améliorations et d’innovations. De plus avec l’arrivée des objets connectés, la diversité de ces supports augmente. Remarquons que beaucoup de constructeurs de contenants sont aussi producteurs de contenus, comme Apple avec toute sa gamme de produits, de logiciels et de services, ou à l’inverse Amazon avec sa tablette tactile connectée à son site de vente en ligne. Cette convergence est de plus en plus présente.

Poursuivons avec les réseaux de télécommunications, qui transportent les informations d’une machine à une autre. Ils comprennent notamment les réseaux Internet, de télévisions et de téléphonie fixe et mobile. Dans chacun de ces secteurs, nous retrouvons des fournisseurs qui se font concurrence. On y fait une première distinction entre les opérateurs historiques, qui souvent gardent une importante part de marché, avec les opérateurs alternatifs et une seconde distinction entre les opérateurs réels qui louent leurs réseaux aux opérateurs virtuels souvent moins cher, low-cost. Par exemple, pour la téléphonie mobile, Orange est un opérateur historique, avec 38,6% de part de marché. Il fait partie des opérateurs réels avec SFR, Bouygues Telecom et Free Mobile. On trouve sur son réseau des opérateurs virtuels (des MVNO) tel que Sosh, M6 mobile ou encore Carrefour mobile.

Aujourd’hui avec la convergence et la concentration des entreprises, les opérateurs deviennent aussi fournisseurs de services. Ils l’hébergent des sites Web et proposent l’accès à des boîtes de courriers électroniques. Nous retrouvons aussi des opérateurs sur plusieurs réseaux. Par exemple les offres Triple Play de FAI (fournisseur d’accès Internet) qui en plus de l’accès à Internet donnent accès à la télévision et au téléphone gratuit vers les fixes et Quadruplay qui rajoute le téléphone gratuit vers les mobiles.

De plus, avec l’explosion du trafic mobile qui se concentre sur quelques acteurs, grands éditeurs mondiaux, les opérateurs doivent assumer les lourds investissements rendus nécessaires dans les réseaux, alors même qu’ils ne profitent principalement qu’aux fournisseurs de contenus et d’applications, comme « GAFA ». Certains estiment que ces géants du Net ne contribuent pas suffisamment aux réseaux qu’ils empruntent et cherchent un moyen de les faire payer pour l’acheminement de leurs contenus.

Continuons avec les autorités légales, qui nous intéressent particulièrement car ce sont elles qui régulent les secteurs du numérique. On y trouve de nombreuses organisations, des Autorités Administratives Indépendantes (AAI), comme l’Autorité de régulation des communications électroniques et des postes (l’ARCEP), ou le Conseil Supérieur de l’Audiovisuel (le CSA). Selon le Conseil d’État (cf rapports-et-etudes) « les autorités administratives indépendantes peuvent être définies comme des organismes administratifs, qui agissent au nom de l’État et disposent d’un réel pouvoir, sans pour autant relever de l’autorité du Gouvernement. L’état participe aussi à la régulation notamment au travers des différentes lois, impôts et taxes. Ainsi ces différents acteurs supervisent l’économie, règlent les conflits, sanctionnent les abus, protègent les consommateurs et les acteurs entre eux… Ils régulent afin de permettre à tout cet univers complexe de mieux fonctionner, pour le bien final de l’usager. Cependant, la tache est difficile car le monde du numérique n’est pas simple et va très vite.

Viennent enfin les usagers. Ce sont les personnes utilisant les réseaux et les contenants, pour obtenir les contenus, sous les règles et le contrôle des autorités légales. Nous pouvons observer que le numérique a changé notre façon de consommer. On veut pouvoir avoir accès à tout, tout de suite et tout le temps.

Eric Scherer, directeur de la prospective à France Télévision a écrit « l’accès permanent à la connaissance, au jeu, au divertissement, devient plus important que sa possession ». On le voit par le streaming qui devient préféré au piratage.

Le numérique est devenu également plus collaboratif, un bon exemple étant Wikipédia. En s’associant, l’Humain a des capacités énormes et les coûts sont dilués. Le Web 2.0 est le contenu produit par l’utilisateur. C’est lui qui donne de la valeur à des entreprises comme Facebook. Et cet accès à l’information pour tous et la parole pour tous grandi l’influence des usagers sur les autres acteurs. Chacun peut être passif ou actif, quoi qu’il arrive le pouvoir de tous grandi.

Alec Ross, conseiller pour l’Innovation d’Hillary Clinton, a dit : « le basculement de pouvoirs le plus important à l’œuvre actuellement ne se passe pas entre l’Occident et l’Asie, les États-Unis et la Chine, le Nord et le Sud, la Droite et la Gauche, mais entre les institutions et les individus, grâce au numérique ».

Nous pouvons d’ailleurs remarquer que les rapports deviennent petit à petit plus horizontaux et plus direct, c’est-à-dire avec moins d’intermédiaire. Le créateur se rapproche du publique qui devient lui-même de plus en plus créateur, le politicien des électeurs.

Certes les rapports deviennent plus horizontaux, mais pas forcément moins verticaux et chacun devient une main d’œuvre gratuite. L’usager détient-il vraiment le pouvoir ? Ne sommes-nous pas simplement manipulés et dépendant du système, des puissants acteurs? Ou ne serait-ce pas plutôt les puissants acteurs qui serait dépendants de nous ?

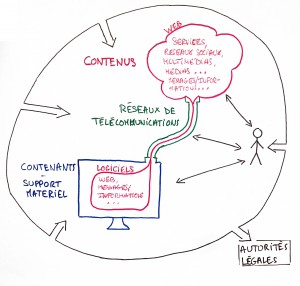

Ci-dessous un schéma qui synthétise et complète la cartographie. Vos suggestions d’améliorations y sont également les bienvenues.

Ainsi, les acteurs ont besoin les uns des autres. Ils sont tous interdépendants. De plus il semblerait qu’une autorégulation se fasse naturellement entre les acteurs d’un même secteur et entre les acteurs de secteurs différents. Par exemple, les utilisateurs en s’alliant ont plusieurs fois fait reculer Facebook. Ainsi ne pouvons-nous pas nous protéger tout seul, avec nos associations de consommateur ? A force d’interagir ensemble, les acteurs ne peuvent-ils pas se réguler d’eux-mêmes ?

Mais quel serait alors le rôle des autorités légales ? Pourquoi régulons-nous ? Pour aborder cette question et dans l’optique de mieux comprendre l’économie numérique il est intéressant d’examiner les principes de base de la concurrence dans ces secteurs puis de regarder l’exemple de l’ARCEP, l’autorité qui régule la concurrence dans le domaine des télécommunications et des postes.

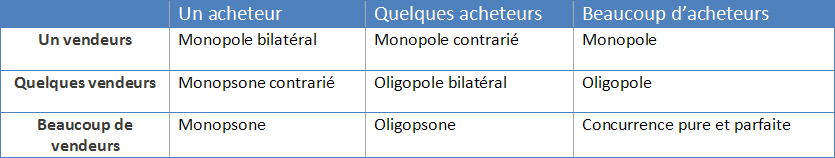

Tout d’abord, qu’est ce que la concurrence ?

La définition de la concurrence est « une compétition, une rivalité entre des personnes, des entreprises, etc., qui ont le même objet et objectif, qui recherchent le même avantage. »

.

En économie, elle désigne « la présence de plusieurs acteurs qui souhaitent accéder à une ressource limitée, par exemple des agents économiques utilisant simultanément une même matière première, ou présents simultanément sur un même marché. Quand elle est sans entrave, elle correspond à une situation de libre confrontation entre l’offre et la demande sur un marché. »

La concurrence est dite pure et parfaite si les offreurs de produits ou de services vendent au prix du marché, aucun d’entre eux ne disposant du pouvoir de fixer les prix ou d’influencer les décisions des autres acteurs. Le prix résulte alors de l’affrontement et de la négociation de l’ensemble des acteurs en partant du coût de sa confection.

Les conditions théoriques nécessaires à une concurrence pure et parfaite sont :

- L’atomicité : les acheteurs et les vendeurs sont suffisamment nombreux pour qu’une décision individuelle ne puisse conduire à une variation de l’offre ou de la demande.

- L’homogénéité des produits : les biens échangés sont semblables et comparables en qualité et en caractéristiques ; un produit de meilleure qualité constitue donc un autre marché.

- La transparence de l’information sur tous les agents et sur le bien échangé.

- La libre entrée et sortie sur le marché : pour une concurrence pure et parfaite, l’accès des offreurs ou des demandeurs sur un marché doit être totalement libre, sans réglementation contraignante

- La parfaite mobilité des acteurs : Les agents et les biens doivent pouvoir librement circuler.

Cependant ce modèle correspond peu à la réalité, ses conditions sont rarement toutes réunies et jamais dans l’économie numérique. Certes le Web a fait progresser ces cinq points dans la diffusion de produits matériels et a ainsi amélioré la concurrence dans ces secteurs. Il n’en est pas tout à fait de même dans l’économie numérique.

Nous sommes ainsi dans un système de concurrence dite imparfaite.

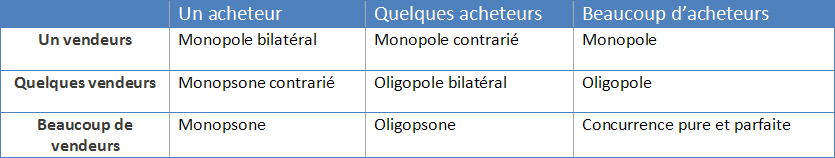

Pour exemple, une concurrence imparfaite où l’atomicité et/ou la liberté d’entrée ne sont pas présentes est le cas où un acteur (monopole) ou un petit groupe d’acteurs (oligopole) a la possibilité de fixer un prix, une quantité ou une qualité, ou bien de s’entendre sur ces conditions.

Les adeptes du libéralisme économique croient que la régulation par des autorités et par les états n’a pas sa place dans l’économie. Selon eux, au fil des années et des interactions entre les acteurs, par l’autorégulation nous atteindrons un jour la concurrence pure et parfaite et le marcher devrait s’équilibrer. Cependant combien de temps devrons-nous attendre avant d’atteindre cet équilibre ? 1 an, 10 ans, 100 ans, 500 ans… Normalement nous ne serons plus là pour en profiter dans 500 ans. Mais peut-on espérer l’atteindre un jour quand on prend en compte la nature de certains hommes à recherche le pouvoir, l’argent ou à ne pas toujours « jouer le jeu » ?

C’est pourquoi en France, bien que nous soyons sous un système économique de libre concurrence, où chacun dispose de la liberté d’exercer une activité, de produire et de vendre aux conditions qu’il souhaite, l’état intervient pour garantir le droit de la concurrence, aussi connu sous l’expression de droit « antitrust » dans le monde anglo-saxon, mais aussi pour garantir les droits et la sécurité des consommateurs.

Le rôle du droit de la concurrence est le plus souvent d’obliger les entreprises à se faire concurrence, ou à la subir. Ce qui préoccupe en cela les autorités légales est entre autre l’efficience économique. Elle est défini par Frédéric Jenny comme « la plus grande satisfaction du consommateur par les producteurs compte tenu de la rareté des ressources globales de la collectivité »

Pour le faire respecter, il est mit en place des autorités de concurrence. Par exemple, L’ARCEP, l’autorité française pour les secteurs des télécommunications et des postes. Elle régule pour que la rareté ne crée pas de situation de monopole. C’est elle qui attribue des licences aux opérateurs physiques et veille à ce que le peu d’acteurs présents sur le marché se livrent bien une concurrence en :

-

Autorisant, voir stimulant la concurrence entre les entreprises pour garantir :

-

Protégeant la concurrence existante en sanctionnant (la sanction prononcée envers Orange et SFR en est un bon exemple)

-

Limitant ou interdisant la concurrence dans certains cas :

-

en autorisant certaines entités à échapper à l’application du droit de la concurrence (but exclusivement sociale, prérogative de puissance publique, garantir la sécurité des consommateurs, …)

-

en concédant provisoirement certains monopoles pour encourager la recherche (propriété intellectuelle des brevets).

Le but des autorités comme l’ARCEP est donc de réguler pour qu’il y ait est de la concurrence qui est nécessaire pour combattre les effets de domination que l’on peut retrouver dans l’économie numérique. La concurrence permet aux consommateurs d’avoir des produits moins chers, plus diversifiés et de meilleure qualité. Pour imager, ces autorités légales apparaissent comme les arbitres d’un jeu.

Cependant cette montée en puissance du droit de la concurrence se confronte à un certain nombre de problèmes. Il est difficile pour les autorités de la concurrence d’analyser cette économie numérique, d’une part à cause de l’évolution et de la technicité des matières, et d’autre part du fait de la délimitation malaisée des secteurs par l’innovation technologique et commerciale permanente, et de la convergence entre les industries et les services, notamment dans les télécommunications, mais aussi dans la télévision et l’Internet.

Par exemple, on observe le développement de nombreux modèles économiques, de modèles d’affaires différents pour un même produit. La concurrence ne se retrouve plus forcément qu’au niveau des produits, mais aussi entre ces modèles d’affaires. Dans une interview intitulée « La révolution numérique : pourquoi parler de nouveaux modèles d’affaires? », parut en 2010 dans le dossier « La révolution numérique : Nouveaux usages, nouveaux modèles, nouvelles régulations ? » de l’ARCEP, Pierre-Jean Benghozi explique :

« De manière paradoxale, ce ne sont plus nécessairement les contenus et les services proposés qui ont une valeur en soi mais les modèles économiques de production et de consommation dans lesquels ils s’inscrivent. »

Par exemple, les modèles basés sur les idéaux de collaboration et de partage prolifèrent et font concurrence aux autres modèles. Ils se traduisent par des biens gratuits, comme les logiciels libres, en open sources, ou les œuvres sous licences Créative Commons (cf les créative commons hackent le droit d’auteur), ou d’autres entreprise en dehors des produits numérique. (cf l’article de Antonin Léonard « Partage, P2P… Bienvenue dans l’économie collaborative! » )

En outre, des tensions naissent constamment entre le droit de la concurrence et le caractère régulé de certains pans de l’économie numérique et la mondialisation a tendance à rendre caduque certaine de ces régulations. Notamment dans le secteur audiovisuel, avec les quotas de diffusion, les obligations d’investissement des chaînes de télévision dans le cinéma, les aides des états, etc… Pour exemple, en France, les chaînes hertziennes n’avaient pas le droit de diffuser des films certains jours, alors qu’aucune contrainte de ce type n’existe sur Internet ou dans d’autre pays. La concurrence n’est donc pas pure et parfaite.

Pour reprendre et approfondir notre image, ce sont des arbitres qui doivent protéger les joueurs les uns des autres et continuellement modifier les règles du jeu en fonction des nouveaux entrants, des nouvelles cartes et des tricheurs. Ce n’est pas une tache aisée.

Pour terminer, on peut révéler deux paradoxes de cette économie numérique.

Le premier, entre sectorisation et convergence. En effet, il est compliqué de délimiter cette économie. Les frontières entre les secteurs sont floues et encore plus avec la convergence, les acteurs se retrouvant de plus en plus sur différents marchés. Toutes représentation graphique en est par cela complexe et à nuancer.

Le deuxième, entre concurrence et concentration. Bien que celle-ci soit forte dans le milieu du numérique, par le fait de nombreux acteurs, on y trouve quand même monopole et oligopole dans différents secteurs. En effet de grandes puissances émergent, notamment le GAFA.

Le modèle économique actuel n’est toujours pas stable et dans certains cas, pas viable. Une seconde bulle Internet, différente de la première, est envisageable. Les changements vont vites et sont nécessaires, plusieurs secteurs sont face à des bouleversements.

Dans son dernier livre, la Troisième révolution industrielle, l’économiste américain Jeremy Rifkin dessine justement les contours d’un nouveau modèle économique et social « Il y diagnostique la fin de l’ère du pétrole et du pouvoir centralisé au profit d’une économie collaborative fondée sur les énergies renouvelables et l’Internet. »

(Cf Interview de Jeremy Rifkin )

Est-ce le changement de cycle que nous prédisaient Les Mayas ?